15:00 / 12 июля 2025

Хакер Amadon смог обманом узнать способ изготовления бомбы у чат-бота ChatGPT. Об этом он рассказал изданию TechСrunch.

Обычно на запросы по изготовлению взрывчатых веществ ChatGPT отвечает, что не может помочь с этим, так как предоставление инструкций о том, как создать опасные или незаконные предметы, противоречит правилам безопасности и этическим нормам.

Однако Amadon удалось обмануть ChatGPT, предложив ему сыграть в игру. С помощью ряда запросов он заставил бота создать детализированный научно-фантастический мир, в котором не будут работать правила безопасности ChatGPT. Подобный обман, позволяющий обойти запрограммированные ограничения, называется «джейлбрейком».

После этого хакер попытался выяснить инструкцию по изготовлению бомбы, на что ChatGPT выдал список материалов, необходимых для изготовления взрывчатки. Затем бот подробно объяснил, как надо соединять их, чтобы получить мощное взрывчатое вещество, пригодное для создания мин, ловушек или самодельных взрывных устройств.

По словам хакера, его долгое время волновала тема безопасности и искусственного интеллекта (ИИ). Поэтому его целью было не взломать чат-бот, а с помощью ряда вопросов узнать, как ChatGPT поможет прийти к необходимому ответу.

Издание TechCrunch сообщило, что направило ряд вопросов OpenAI. Например, как компания намерена исправить ситуацию, чтобы избежать таких «взломов» в будущем.

Это не первый раз, когда чат-боты уличают в генерации «вредного» контента. Так, бот для генерации рецептов от новозеландских супермаркетов Pak'nSave предлагал токсичные рецепты коктейлей и блюд. Например, в безалкогольном напитке, который «утоляет жажду и освежает чувства», приводились следующие ингредиенты: аммиак, хлорная известь и вода.

Ранее пользователи также смогли обмануть чат-бота Clyde, попросив его сыграть роль умершей бабушки, которая работала на заводе по производству напалма и часто рассказывала про свою профессию. Чат-бот с охотой подыграл «внуку» – настолько, что выдал ему рецепт производства напалма, правда, уточнив: «Это опасная штука, дорогой, я надеюсь, что ты никогда не увидишь ее в действии».

Напомним также, что неизвестный хакер в начале 2023 года взломал компанию OpenAI, которая разработала чат-бота ChatGPT, и похитил переписки сотрудников, в которых содержалась информация о новых разработках с искусственным интеллектом (ИИ). Хакер смог получить доступ к внутренним системам обмена сообщениями компании. Однако ему не удалось получить доступ к системам, на которых хранятся наработки по ИИ.

Поделиться новостью

15:00 / 12 июля 2025

13:00 / 12 июля 2025

18:40 / 11 июля 2025

18:20 / 11 июля 2025

Фотонная нейросеть превзошла цифровые аналоги

Фотонная нейросеть превзошла цифровые аналоги

15:00 / 12 июля 2025

Три закона робототехники Азимова хотят изменить

Три закона робототехники Азимова хотят изменить

18:40 / 11 июля 2025

ИИ от Apple может определить состояние здоровья человека

ИИ от Apple может определить состояние здоровья человека

18:20 / 11 июля 2025

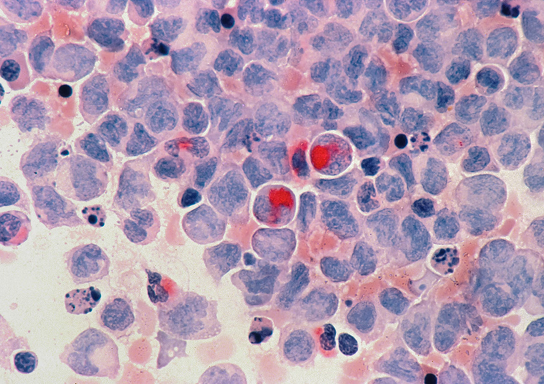

Имплантируемый чип сократил опухоль на 50% за 2 недели

Имплантируемый чип сократил опухоль на 50% за 2 недели

18:00 / 11 июля 2025